Москва, Россия — 16 августа 2024 г.

Ученые из лаборатории исследований искусственного интеллекта (ИИ)

В перспективе это позволит шире применять языковые модели в бизнесе, так как сейчас их использование ограничивают высокие затраты на вычислительные мощности. Кроме того, снижение потребления энергии в области вычислений, особенно в больших центрах обработки данных, поможет уменьшить негативное влияние на окружающую среду и сократить выбросы парниковых газов.

Результаты исследования были признаны мировым научным сообществом и представлены на

Научную работу цитировали одни из самых известных исследователей эффективности искусственного интеллекта в мире, представляющие Принстонский университет и Университет Карнеги — Меллона. Почти все языковые модели в мире используют именно их наработки.

Суть открытия

В основе открытия лежит новая архитектура языковых моделей, названная ReBased. Архитектура в глубоком обучении — это общий план или структура, по которой строится нейронная сеть. Она определяет, какие типы слоев будут использованы (например, сверточные, рекуррентные или полносвязные) и как эти слои будут соединены между собой. Проще говоря, это как проект дома, где есть план этажей, комнаты и их соединения. Хорошо продуманная архитектура позволяет нейросети лучше решать определенные задачи, например распознавать изображения или понимать текст. Выбор подходящей архитектуры важен для эффективности и точности работы модели.

Самые распространенные языковые модели основаны на архитектуре «Трансформер», представленной в 2017 году исследователями из Google. Они хорошо зарекомендовали себя при решении практических задач, но для них требуется очень большое количество ресурсов, которые растут квадратично с удлинением текста. Для широкого практического применения необходимы менее ресурсозатратные архитектуры.

Наиболее успешные конкуренты трансформеров — последние

В модели Based, представленной учеными Стэнфорда в декабре 2023 года, которая значительно улучшила способности контекстного обучения,

специалисты

Проведя анализ архитектуры Based, ученые из

ReBased способна снизить издержки на использование искусственного интеллекта для специализированных задач, которые имеют конкретную область применения и требуют учета ее особенностей. Например, в медицине такой задачей может считаться классификация текстов на основе симптомов и диагнозов.

Новая архитектура, предложенная учеными, позволяет приблизить качество линейных моделей к трансформерам. Модели, в основе которых лежит ReBased, могут генерировать тексты с более низкими требованиями к ресурсам практически без потери качества.

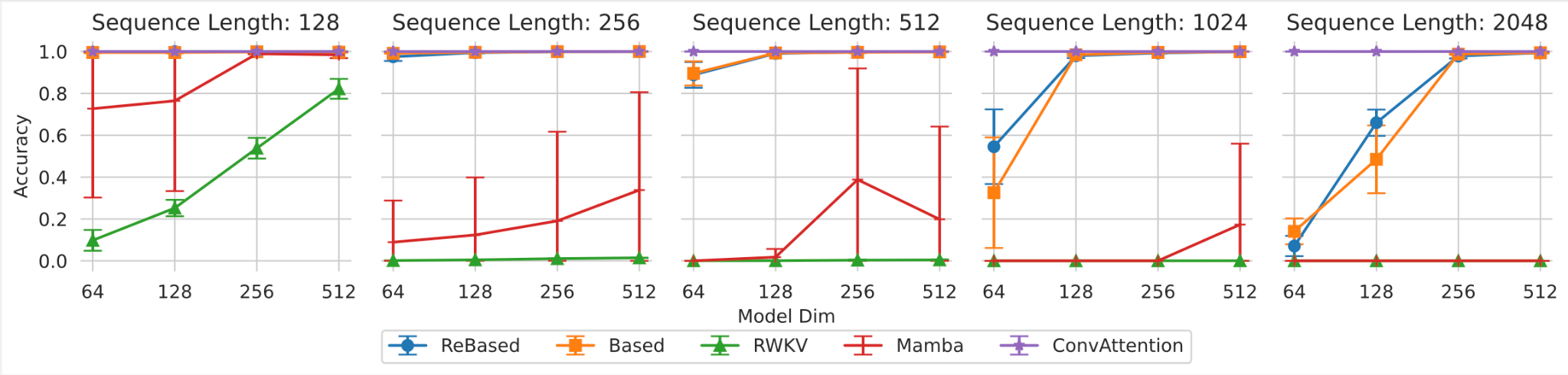

Ученые проводили эксперименты на датасете MQAR (

Рис. 1. Результаты по набору данных MQAR, разработанному для измерения возможностей контекстного обучения архитектуры Arora и др. (2024). ReBased превосходит все эффективные модели в возможностях контекстного обучения

Ярослав Аксенов, исследователь обработки естественного языка в

«Примечательно, что параллельно с выходом нашей статьи группа исследователей из Стэнфорда выпустила исследование на эту же тему, но с другим подходом к решению. Сейчас это одна из наиболее интересных областей исследований в NLP по всему миру: трансформеры слишком медленные, но линейные модели уступают им по качеству. И мы, и ученые из Стэнфорда занимаемся поиском оптимальных архитектур. Мы ценим их вклад в развитие технологий и рады возможности участвовать в научном диалоге такого уровня».

В перспективе линейные модели все чаще будут использоваться в комбинации с трансформерами в качестве составной части гибридных архитектур. Такие архитектуры сочетают в себе и скорость, и высокое качество выполнения задач.

Подробное описание модели и результаты экспериментов доступны в статье

Linear Transformers with Learnable Kernel Functions are Better

Исходный код и дополнительные материалы можно найти на GitHub.

Лаборатория

Ученые из

За три года существования команды более 20 статей были приняты на крупнейшие конференции и воркшопы в области ИИ. Научные работы

Команда курирует исследовательские лаборатории

Похожие новости